GRU(门控循环单元),易懂。 - CSDN博客

2022年2月4日 · 门控循环单元(GRU)是一种循环神经网络(Recurrent Neural Network,RNN)的变种,用于处理序列数据。与传统的RNN相比,GRU在捕捉序列数据中的长期依赖关系时表现更出色。它是一种效率更高、训练速度更快的RNN变体。

【NLP】第四章:门控循环单元GRU - 知乎 - 知乎专栏

2025年2月2日 · GRU是在2014年Cho,etal.《Empirical Evaluation of Gated Recurrent Neural Networks on Sequence Modeling》(门控循环神经网络在序列建模上的实证评估)论文中提出的,是目前非常流行的一个变体,因为它比LSTM网络要简单,但在某些情况能产生同样出色的效果。

深度探索:机器学习门控循环单元 (GRU)算法原理及其应用_gru算 …

2024年4月11日 · 门控循环单元(GRU)是一种循环神经网络(Recurrent Neural Network,RNN)的变种,用于处理序列数据。与传统的RNN相比,GRU在捕捉序列数据中的长期依赖关系时表现更出色。它是一种效率更高、训练速度更快的RNN变体。

深度学习好文-一文带你深入理解GRU门控循环单元-CSDN博客

2025年2月19日 · GRU(门控循环单元,Gated Recurrent Unit) 是一种常用的循环神经网络(RNN)结构,它被设计用来解决标准 RNN 中存在的梯度消失问题,并且在很多任务中能有效捕捉长时间依赖关系。 GRU 是由 Cho et al. 在 2014 年提出的,它的设计简化了长短期记忆网络(LSTM)的结构,同时保持了类似的性能。

经典必读:门控循环单元(GRU)的基本概念与原理 | 机器之心

2017年12月24日 · 在本文中,我们将讨论相当简单且可理解的神经网络模型:门控循环单元(GRU)。根据 Cho, et al. 在 2014 年的介绍,GRU 旨在解决标准 RNN 中出现的梯度消失问题。GRU 也可以被视为 LSTM 的变体,因为它们基础的理念都是相似的,且在某些情况能产生同样出 …

9.1. 门控循环单元(GRU) — 动手学深度学习 2.0.0 documentation

门控循环单元(gated recurrent unit,GRU) (Cho et al., 2014) 是一个稍微简化的变体,通常能够提供同等的效果, 并且计算 (Chung et al., 2014) 的速度明显更快。 由于门控循环单元更简单,我们从它开始解读。

通俗易懂GRU|门控循环单元 (gated recurrent unit, GRU) - 知乎

为此,Cho、van Merrienboer、 Bahdanau和Bengio[1]在2014年提出了GRU门控循环单元,这个结构如图 4.53所示,是对LSTM的一种改进。 它将遗忘门和输入门合并成更新门,同时将记忆单元与隐藏层合并成了重置门,进而让整个结构运算变得更加简化且性能得以增强。

《动手学深度学习》9.1学习笔记——门控循环单元(GRU) - 知乎

门控循环单元(Gated Recurrent Unit,GRU)是一种循环神经网络(RNN)的变体,旨在解决传统 RNN 在处理长序列数据时容易出现的梯度消失和梯度爆炸问题,同时相对另一种常见的 RNN 变体长短期记忆网络(LSTM),它…

门控循环单元(Gate Recurrent Unit,GRU) - CSDN博客

2022年5月1日 · 门控循环单元(Gated Recurrent Unit,简称GRU)是一种简化版的LSTM(长短期记忆网络),专门用于解决长序列中的梯度消失问题。 与 LSTM 相比, GRU 具有更简单的结构和较少的参数,但在许多任务上表现出类似的性能,因此被广泛应用于自然语言处理(NLP)、时 …

GRU(门控循环单元)原理+ 代码实现 - kalice - 博客园

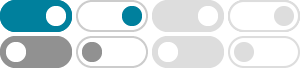

2021年11月13日 · gru(门控循环单元)原理+ 代码实现 GRU说白了就是加了两个门,这两个门控制最终隐藏状态的输出,其中还是那一套换汤不换药。 R是重置门,决定上一个时间步 \(h_{t-1}\) 是否要被重置,如果R元素全为0,很显然我们就丢掉了上一个时间步的h信息。